AI技术百科

小小程序员

2021-05-15 23:31:34

修正线性单元 Rectified Linear Unit

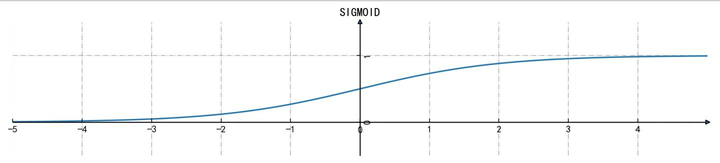

一、Rectified Linear Unit:sigmoid函数

若用sigmoid、双曲正切或softsign这种逻辑函数来做回归,将会不可避免地遭遇函数“饱和”,即x取值过大或过小,函数值接近常数,梯度消失。

一般来说神经网络小于5层可以用sigmoid类的饱和激活函数,超过5层就应该使用非饱和激活函数。

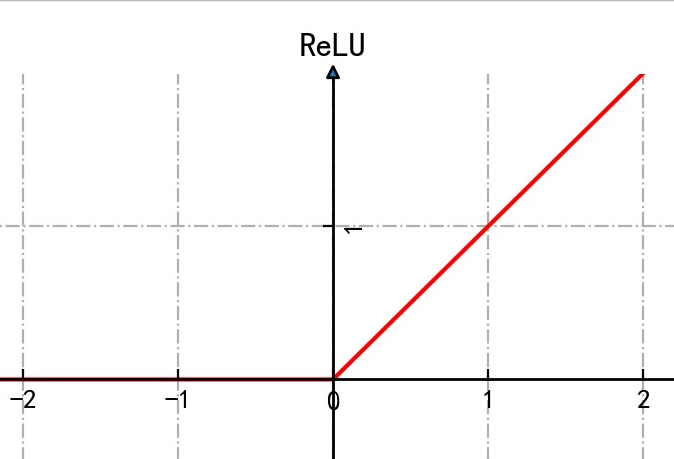

二、ReLU,rectified linear unit,修正线性单元

相比sigmoid:

使用梯度下降法时,收敛速度更快

计算速度更快

更仿生

但是如果神经元出现了误判,x掉到了左边的常数区域,只要x<0,输出恒为0 。梯度又消失了,神经元无法更新参数无法学习,Dead Neuron。

条内容

条内容